Πώς να χρησιμοποιήσετε τα μοντέλα AI της Ollama offline στο ONLYOFFICE

Η ενσωμάτωση των τοπικών LLMs της Ollama με τους επεξεργαστές του ONLYOFFICE φέρνει τα πιο προηγμένα χαρακτηριστικά AI απευθείας στους επεξεργαστές σας, χωρίς να θυσιάζετε την ιδιωτικότητα ή την ταχύτητα. Ακολουθήστε τα παραπάνω βήματα για να ξεκλειδώσετε έναν ισχυρό, offline βοηθό AI για όλες τις ροές εργασίας σας που σχετίζονται με κείμενο.

Γιατί τα τοπικά μοντέλα AI είναι σημαντικά

Η ανάπτυξη τοπικών μοντέλων AI εξασφαλίζει ότι ευαίσθητα έγγραφα δεν εγκαταλείπουν ποτέ τον υπολογιστή σας, διατηρώντας την εμπιστευτικότητα και τη συμμόρφωση με τους κανονισμούς δεδομένων.

Η εκτέλεση μοντέλων offline εξαλείφει την καθυστέρηση του δικτύου, προσφέροντας σχεδόν άμεσα αποτελέσματα για εργασίες όπως σύνοψη, μετάφραση και δημιουργία περιεχομένου.

Εσείς αποφασίζετε ποια μοντέλα να εκτελέσετε – η Ollama παρέχει ένα ελαφρύ, επεκτάσιμο πλαίσιο για διάφορα τοπικά LLMs, συμπεριλαμβανομένης της οικογένειας Ollama, DeepSeek, Mistral και άλλα.

Βήμα 1. Εγκαταστήστε το Homebrew (Προαιρετικό)

Εάν προτιμάτε να χρησιμοποιείτε το Homebrew για τη διαχείριση πακέτων σε macOS ή Linux, εγκαταστήστε το εκτελώντας:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

Εάν επιλέξετε να εγκαταστήσετε την Ollama χρησιμοποιώντας άλλη μέθοδο, μπορείτε να παραλείψετε αυτό το βήμα.

Βήμα 2. Εγκαταστήστε την Ollama

Για να εγκαταστήσετε την Ollama, χρησιμοποιήστε το επίσημο σενάριο εγκατάστασης:

curl -fsSL https://ollama.com/install.sh | sh

Εναλλακτικά, εάν χρησιμοποιείτε Homebrew, μπορείτε να εγκαταστήσετε την Ollama εκτελώντας:

brew install ollama

Μόλις εγκατασταθεί, η Ollama εκθέτει εντολές για εξυπηρέτηση, λίστα, επιθεώρηση και εκτέλεση μοντέλων στον υπολογιστή σας.

Βήμα 3. Εκκινήστε τον τοπικό διακομιστή AI

Για να επιτρέψετε στο ONLYOFFICE να επικοινωνήσει με τον τοπικό διακομιστή Ollama σας, θα χρειαστεί να τον ρυθμίσετε να δέχεται αιτήματα από εφαρμογές ιστού.

Στο Terminal, εκτελέστε:

export OLLAMA_ORIGINS=http://*,https://*

Για να ξεκινήσετε την Ollama τώρα και να επανεκκινήσει κατά τη σύνδεση:

brew services start ollama

Ή, εάν δεν θέλετε/χρειάζεστε μια υπηρεσία παρασκηνίου, μπορείτε απλά να εκτελέσετε:

ollama serve

Βήμα 4. Κατεβάστε και εκτελέστε ένα μοντέλο

Ανοίξτε ένα άλλο παράθυρο Terminal και τραβήξτε το μοντέλο που θα θέλατε να χρησιμοποιήσετε. Για παράδειγμα, για να εγκαταστήσετε και να εκτελέσετε το Llama 3.2:

ollama run llama3.2

Αυτό θα κατεβάσει το μοντέλο και θα το ξεκινήσει τοπικά. Μπορείτε να εγκαταστήσετε όσα μοντέλα θέλετε. Κάθε ένα θα εμφανιστεί στη λίστα επιλογής μοντέλων του ONLYOFFICE. Εξερευνήστε περισσότερα μοντέλα στον επίσημο κατάλογο μοντέλων της Ollama.

Σημείωση: Πριν την εγκατάσταση, βεβαιωθείτε ότι ο υπολογιστής σας διαθέτει επαρκή μνήμη και χώρο δίσκου για τα μοντέλα.

Βήμα 5. Ρυθμίστε το πρόσθετο AI στο ONLYOFFICE

Πρώτα, εγκαταστήστε το πρόσθετο AI για τους επεξεργαστές του ONLYOFFICE. Εάν έχετε ήδη εγκαταστήσει το πρόσθετο AI, ακολουθήστε το επόμενο βήμα.

Ανοίξτε οποιονδήποτε επεξεργαστή του ONLYOFFICE σε ένα πρόγραμμα περιήγησης ιστού. Μεταβείτε στο Πρόσθετα -> Διαχείριση πρόσθετων, βρείτε το πρόσθετο AI και κάντε κλικ στο Εγκατάσταση.

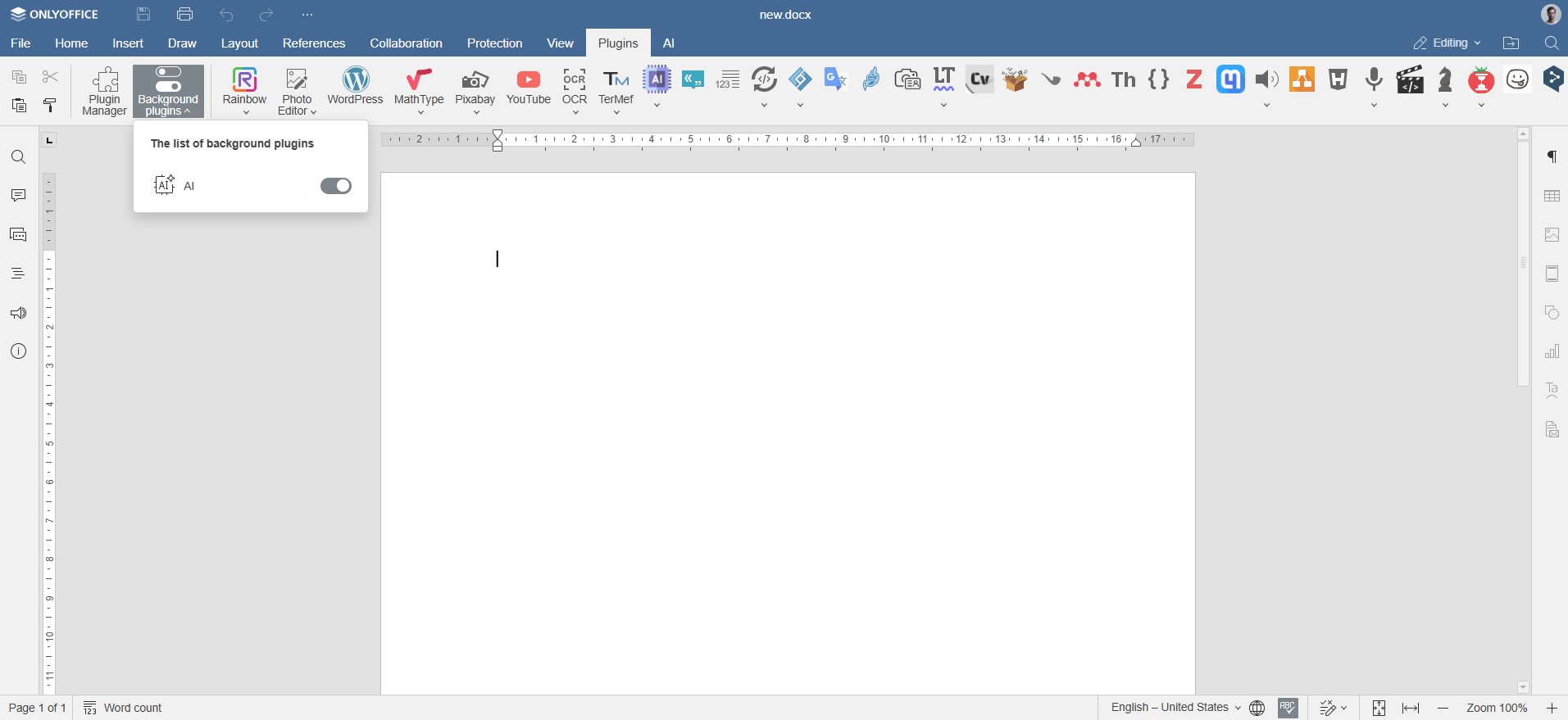

Ενεργοποιήστε το πρόσθετο μέσω Πρόσθετα -> Πρόσθετα παρασκηνίου.

Βήμα 6. Προσθέστε μοντέλα Ollama

Πλοηγηθείτε στην καρτέλα AI στο ONLYOFFICE και κάντε κλικ στο εικονίδιο Ρυθμίσεις. Στην ενότητα Επεξεργασία μοντέλων AI, κάντε κλικ στο εικονίδιο +.

Επιλέξτε την Ollama ως πάροχο και ορίστε τη διεύθυνση URL σε http://localhost:11434.

Επιλέξτε το εγκατεστημένο μοντέλο σας (π.χ., llama3.2:latest) από την πτυσσόμενη λίστα και επιβεβαιώστε.

Βήμα 7. Αντιστοιχίστε εργασίες στα μοντέλα Ollama

Επιστρέψτε στη διαμόρφωση AI. Από την πτυσσόμενη λίστα, επιλέξτε τα εγκατεστημένα μοντέλα AI που θα εκτελούν αυτές τις εργασίες, όπως επεξεργασία κειμένου, σύνοψη ή δημιουργία κώδικα, και αποθηκεύστε τις ρυθμίσεις.

Το μοντέλο είναι τώρα συνδεδεμένο και έτοιμο για χρήση στους επεξεργαστές του ONLYOFFICE.

Πώς να χρησιμοποιήσετε τα μοντέλα AI της Ollama με τους επεξεργαστές του ONLYOFFICE

Μόλις ρυθμίσετε την Ollama και συνδέσετε τα προτιμώμενα μοντέλα σας, μπορείτε να αρχίσετε να αλληλεπιδράτε μαζί της απευθείας από τους επεξεργαστές του ONLYOFFICE. Πλοηγηθείτε στην καρτέλα AI ή απλά κάντε δεξί κλικ σε οποιοδήποτε επιλεγμένο κείμενο για να αποκτήσετε πρόσβαση σε λειτουργίες που τροφοδοτούνται από AI.

Ανοίξτε την καρτέλα AI ή κάντε δεξί κλικ στο επιλεγμένο κείμενο για να το αναδιατυπώσετε, να το εξηγήσετε ή να το συνοψίσετε. Επιλέξτε πώς να εισαγάγετε το αποτέλεσμα: αντικατάσταση του αρχικού, προσθήκη σχολίου ή τοποθέτηση κάτω από το κείμενο.

Μπορείτε να χρησιμοποιήσετε τα μοντέλα AI για:

- Δημιουργία νέου περιεχομένου ή ιδεών για τις αναφορές, τις αναρτήσεις ιστολογίου ή τα email σας

- Σύνοψη πολύπλοκων εγγράφων ή άρθρων αμέσως

- Μετάφραση κειμένου μεταξύ γλωσσών

- Βελτίωση της σαφήνειας και της γραμματικής της γραφής

- Λήψη γρήγορης βοήθειας ή παραδειγμάτων κώδικα (εάν το μοντέλο το υποστηρίζει)

- Εξερεύνηση του πλαισίου και της χρήσης όρων στη γραφή σας

Παρακαλώ σημειώστε: Οι απαντήσεις AI δημιουργούνται από μοντέλα τρίτων. Το ONLYOFFICE δεν αναλαμβάνει ευθύνη για την ακρίβεια του περιεχομένου που παράγεται από αυτά τα εργαλεία. Πάντα ελέγχετε διπλά τα ευαίσθητα ή κρίσιμα αποτελέσματα.

Δημιουργήστε τον δωρεάν λογαριασμό ONLYOFFICE σας

Online προβολή, επεξεργασία και συνεργασία σε έγγραφα, υπολογιστικά φύλλα, παρουσιάσεις, φόρμες και αρχεία PDF.