Come utilizzare i modelli AI di Ollama offline in ONLYOFFICE

Integrare i modelli LLM locali di Ollama con gli editor di ONLYOFFICE porta nuove funzionalità AI all’avanguardia direttamente nei tuoi editor, senza compromettere la privacy o la velocità. Segui i passaggi indicati qui sotto per utilizzare un potente assistente AI offline che ti permetterà di migliorare tutti i tuoi flussi di lavoro legati al testo.

Perché i modelli AI locali sono importanti

L’esecuzione locale dei modelli AI garantisce che i documenti sensibili non lascino mai il tuo dispositivo, preservando la riservatezza e la conformità alle normative sulla protezione dei dati.

L’esecuzione offline elimina la latenza di rete, offrendo risultati quasi istantanei per attività come sintesi, traduzione e generazione di contenuti.

Sei tu a decidere quali modelli eseguire: Ollama offre un framework leggero ed estensibile per diversi LLM locali, inclusi quelli della famiglia Ollama, DeepSeek, Mistral e altri.

Passaggio 1. Installa Homebrew (facoltativo)

Se preferisci usare Homebrew per gestire i pacchetti su macOS o Linux, installalo eseguendo:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

Se scegli di installare Ollama con un altro metodo, puoi saltare questo passaggio.

Passaggio 2. Installa Ollama

Per installare Ollama, utilizza lo script di installazione ufficiale:

curl -fsSL https://ollama.com/install.sh | sh

In alternativa, se utilizzi Homebrew, puoi installare Ollama eseguendo:

brew install ollama

Una volta installato, Ollama espone i comandi per servire, elencare, ispezionare ed eseguire i modelli sulla tua macchina.

Passaggio 3. Avvia il server AI locale

Per permettere a ONLYOFFICE di comunicare con il server Ollama locale, è necessario configurarlo per accettare richieste dalle applicazioni web.

Nel Terminale, esegui:

export OLLAMA_ORIGINS=http://,https://

Per avviare subito Ollama e riavviarlo al login:

brew services start ollama

Oppure, se non vuoi/non hai bisogno di un servizio in background, puoi semplicemente eseguire:

ollama serve

Passaggio 4. Scarica ed esegui un modello

Apri un’altra finestra del Terminale e scarica il modello che desideri utilizzare. Ad esempio, per installare ed eseguire Llama 3.2:

ollama run llama3.2

Questo comando scaricherà il modello e lo avvierà localmente. Puoi installare quanti modelli desideri e ognuno apparirà nell’elenco dei modelli selezionabili in ONLYOFFICE. Esplora altri modelli nella lista ufficiale dei modelli Ollama.

Nota: prima dell’installazione, assicurati che il tuo dispositivo disponga di memoria e spazio su disco sufficienti per i modelli.

Passaggio 5. Configura il plugin AI in ONLYOFFICE

Per prima cosa, installa il plugin AI per gli editor di ONLYOFFICE. Se hai già installato il plugin, passa al passaggio successivo.

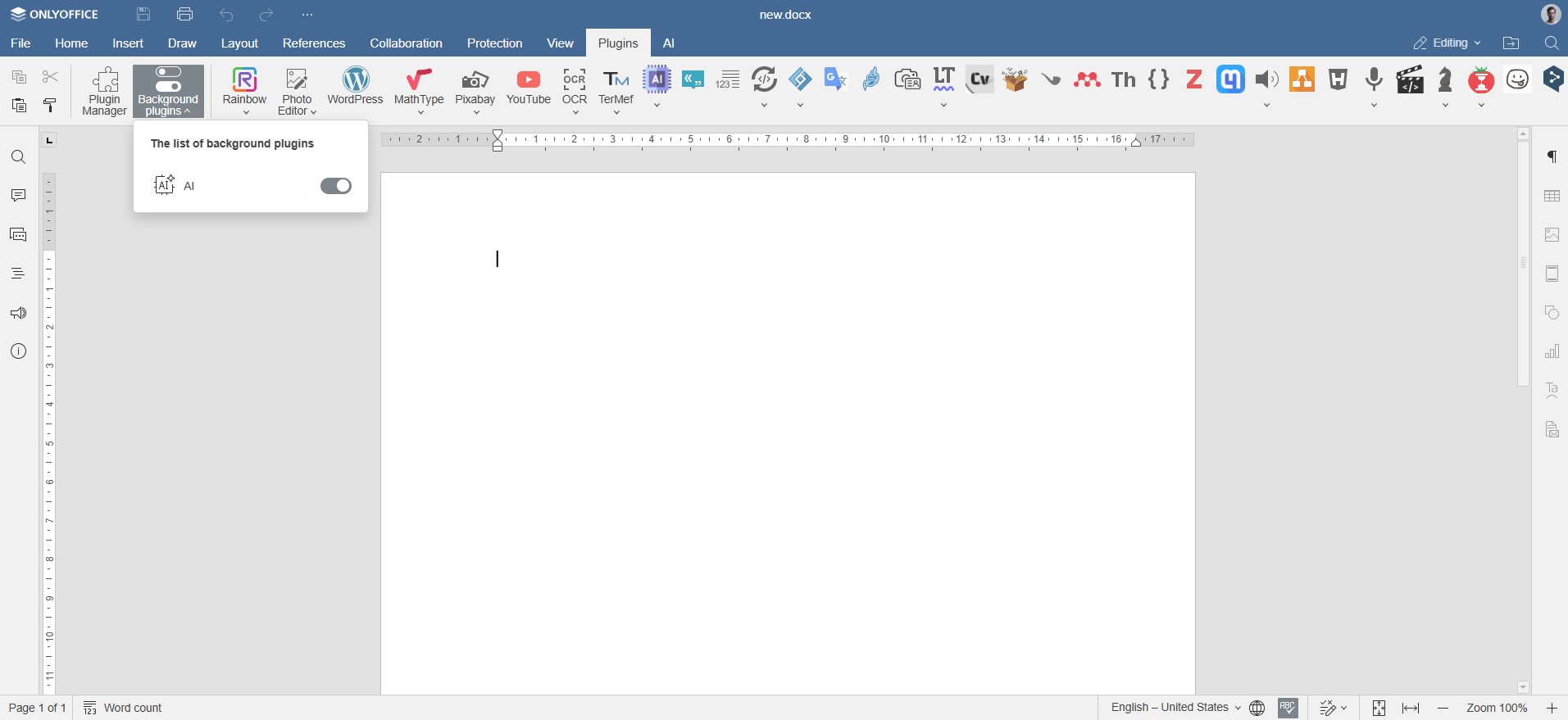

Apri un qualsiasi editor di ONLYOFFICE nel browser. Vai su Plugin -> Plugin Manager, trova il plugin AI e fai clic su Installa.

Attiva il plugin tramite Plugin -> Plugin in background.

Passaggio 6. Aggiungi i modelli Ollama

Vai alla scheda AI in ONLYOFFICE e fai clic sull’icona delle Impostazioni. Sotto Modifica modelli AI, fai clic sull’icona + .

Scegli Ollama come provider e imposta l’URL su http://localhost:11434.

Seleziona il modello installato (ad esempio, llama3.2:latest) dal menù a tendina e conferma.

Passaggio 7. Assegna compiti ai modelli Ollama

Torna alla configurazione AI. Dal menù a tendina, seleziona i modelli AI installati che eseguiranno attività come elaborazione del testo, sintesi o generazione di codice, quindi salva le impostazioni.

Il modello è ora connesso e pronto per essere utilizzato negli editor di ONLYOFFICE.

Come usare i modelli AI di Ollama con gli editor di ONLYOFFICE

Una volta configurato Ollama e collegati i modelli desiderati, puoi iniziare a interagire con essi direttamente dagli editor di ONLYOFFICE. Vai alla scheda AI o fai clic con il tasto destro su un testo selezionato per accedere alle funzionalità basate sull’AI.

Apri la scheda AI o fai clic con il tasto destro sul testo selezionato per riformulare, spiegare o riassumere il contenuto. Scegli come inserire il risultato: sostituire il testo originale, aggiungere un commento o posizionarlo sotto al testo.

Puoi utilizzare i modelli AI per:

- Generare nuovi contenuti o idee per report, post sul blog o email

- Riassumere all’istante documenti o articoli complessi

- Tradurre testo tra diverse lingue

- Migliorare chiarezza e grammatica nella scrittura

- Ottenere rapidamente esempi o aiuto nel codice (se supportato dal modello)

- Esplorare il contesto e l’uso di termini nei tuoi testi

Nota: Le risposte AI sono generate da modelli di terze parti. ONLYOFFICE non è responsabile per l’accuratezza dei contenuti prodotti da questi strumenti. Verifica sempre i risultati sensibili o critici.

Crea il tuo account ONLYOFFICE gratuito

Visualizza, modifica e collabora su documenti, fogli, diapositive, moduli e file PDF online.