Comment utiliser les modèles d’IA d’Ollama hors ligne dans ONLYOFFICE

L’intégration des LLM locaux d’Ollama avec les éditeurs ONLYOFFICE apporte des fonctionnalités d’IA de pointe directement dans vos éditeurs, sans sacrifier la confidentialité ou la vitesse. Suivez les étapes ci-dessus pour débloquer un puissant assistant d’IA hors ligne pour tous vos flux de travail liés au texte.

Pourquoi les modèles d’IA locaux sont-ils importants

Le déploiement local de modèles d’IA garantit que les documents sensibles ne quittent jamais votre machine, préservant ainsi la confidentialité et la conformité aux réglementations sur les données.

L’exécution des modèles hors ligne élimine la latence du réseau, ce qui permet d’obtenir des résultats quasi instantanés pour des tâches telles que le résumé, la traduction et la génération de contenu.

Vous décidez des modèles à exécuter – Ollama fournit un cadre léger et extensible pour divers LLM locaux, y compris la famille Ollama, DeepSeek, Mistral et bien d’autres.

Étape 1. Installer Homebrew (optionnel)

Si vous préférez utiliser Homebrew pour gérer les paquets sur macOS ou Linux, installez-le en exécutant :

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

Si vous choisissez d’installer Ollama en utilisant une autre méthode, vous pouvez sauter cette étape.

Étape 2. Installer Ollama

Pour installer Ollama, utilisez le script d’installation officiel :

curl -fsSL https://ollama.com/install.sh | sh

Alternativement, si vous utilisez Homebrew, vous pouvez installer Ollama en exécutant :

brew install ollama

Une fois installé, Ollama expose des commandes pour servir, lister, inspecter et exécuter des modèles sur votre machine.

Étape 3. Lancer le serveur AI local

Pour permettre à ONLYOFFICE de communiquer avec votre serveur Ollama local, vous devez le configurer pour qu’il accepte les requêtes des applications web.

Dans le terminal, exécutez :

export OLLAMA_ORIGINS=http://*,https://*,onlyoffice://*

Pour démarrer Ollama maintenant et le redémarrer à la connexion :

brew services start ollama

Ou, si vous ne voulez pas ou n’avez pas besoin d’un service d’arrière-plan, vous pouvez simplement l’exécuter :

ollama serve

Étape 4. Télécharger et exécuter un modèle

Ouvrez une autre fenêtre de Terminal et tirez le modèle que vous souhaitez utiliser. Par exemple, pour installer et exécuter Llama 3.2 :

ollama run llama3.2

Ceci téléchargera le modèle et le démarrera localement. Vous pouvez installer autant de modèles que vous le souhaitez. Chacun d’entre eux apparaîtra dans la liste de sélection du modèle ONLYOFFICE. Découvrez d’autres modèles sur la liste officielle des modèles Ollama.

Note : Avant l’installation, assurez-vous que votre machine dispose de suffisamment de mémoire et d’espace disque pour les modèles.

Étape 5. Configurer le plugin AI dans ONLYOFFICE

Tout d’abord, installez le plugin IA pour les éditeurs ONLYOFFICE. Si vous avez déjà installé le plugin, suivez l’étape suivante.

Ouvrez n’importe quel éditeur ONLYOFFICE dans un navigateur web. Allez dans Modules complémentaires -> Gestionnaire de plugins, trouvez le plugin IA et cliquez sur Installer.

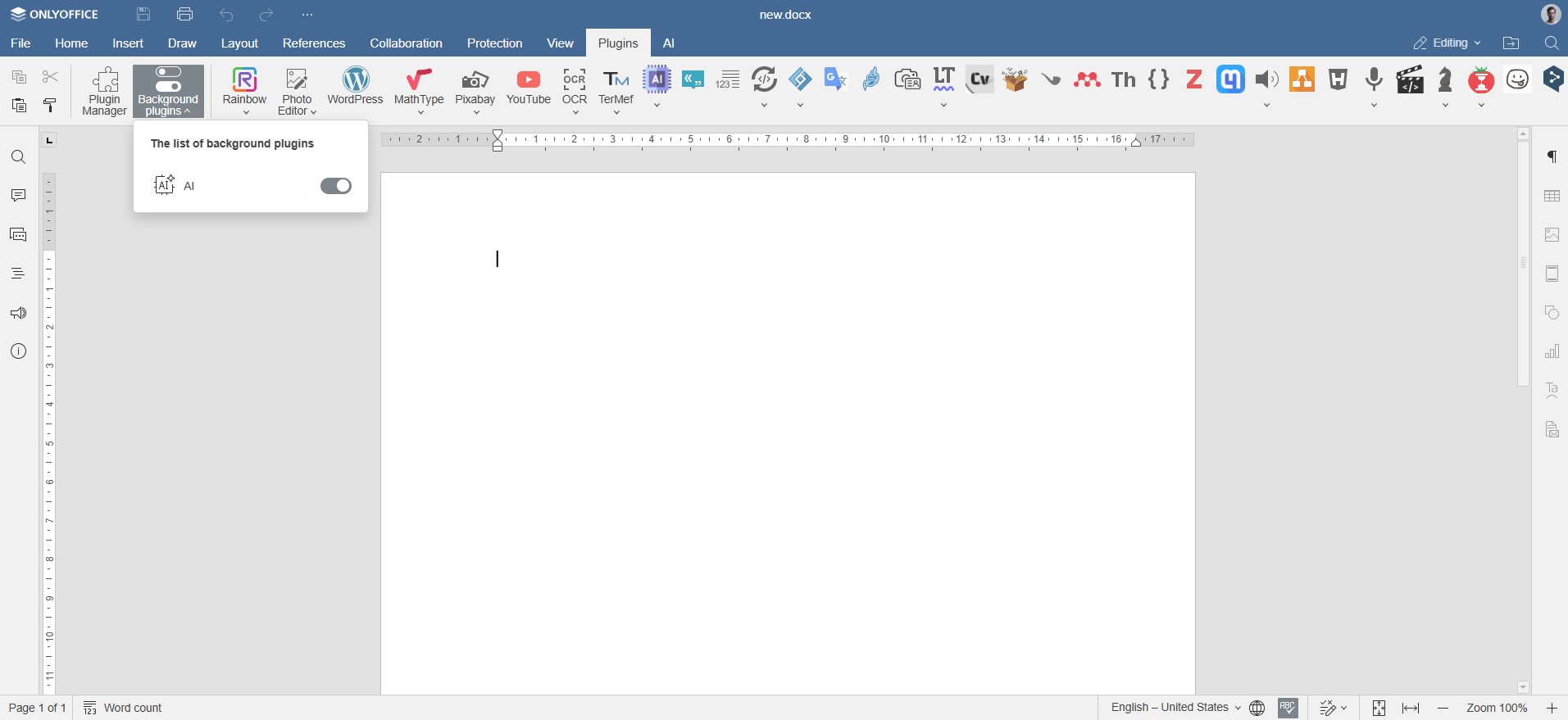

Activez le plugin via Modules complémentaires -> Plugins d’arrière-plan.

Étape 6. Ajouter des modèles Ollama

Naviguez vers l’onglet IA dans ONLYOFFICE et cliquez sur l’icône Paramètres. Sous Modifier les modèles AI, cliquez sur l’icône +.

Choisissez Ollama comme fournisseur et définissez l’URL comme suit http://localhost:11434.

Sélectionnez le modèle installé (par exemple, llama3.2:latest) dans la liste déroulante et confirmez.

Étape 7. Attribuer des tâches aux modèles Ollama

Revenez à la configuration de l’IA. Dans la liste déroulante, sélectionnez les modèles d’IA installés qui effectueront ces tâches, telles que le traitement de texte, le résumé ou la génération de code, et enregistrez les paramètres.

Le modèle est maintenant connecté et prêt à être utilisé dans les éditeurs ONLYOFFICE.

Comment utiliser les modèles d’IA d’Ollama avec les éditeurs d’ONLYOFFICE

Une fois que vous avez configuré Ollama et connecté vos modèles préférés, vous pouvez commencer à interagir avec lui directement depuis les éditeurs d’ONLYOFFICE. Naviguez vers l’onglet IA ou cliquez simplement avec le bouton droit de la souris sur n’importe quel texte sélectionné pour accéder aux fonctions pilotées par l’IA.

Ouvrez l’onglet IA ou cliquez avec le bouton droit de la souris sur le texte sélectionné pour reformuler, expliquer ou résumer le contenu. Choisissez comment insérer le résultat : remplacez l’original, ajoutez un commentaire ou placez-le sous le texte.

Vous pouvez utiliser des modèles d’IA pour :

- Générer de nouveaux contenus ou d’idées pour vos rapports, vos articles de blog ou vos e-mails

- Résumer instantanément des documents ou des articles complexes

- Traduire un texte d’une langue à l’autre

- Améliorer la clarté de l’écriture et la grammaire

- Obtenir rapidement une aide au codage ou des exemples (si le modèle le permet)

- Explorer le contexte et l’utilisation des termes dans vos écrits

Remarque : les réponses de l’IA sont générées par des modèles tiers. ONLYOFFICE n’est pas responsable de l’exactitude du contenu produit par ces outils. Vérifiez toujours les résultats sensibles ou critiques.

Créez votre compte ONLYOFFICE gratuit

Affichez, modifiez et coéditez des documents texte, feuilles de calcul, diapositives, formulaires et fichiers PDF en ligne.