So verwenden Sie Ollama-KI-Modelle offline in ONLYOFFICE

Die Integration der lokalen LLMs von Ollama in die ONLYOFFICE-Editoren bringt modernste KI-Funktionen direkt in Ihre Editoren, ohne Kompromisse bei Datenschutz oder Geschwindigkeit einzugehen. Folgen Sie den obigen Schritten, um einen leistungsstarken Offline-KI-Assistenten für alle Ihre textbezogenen Workflows freizuschalten.

Warum lokale KI-Modelle wichtig sind

Die lokale Bereitstellung von KI-Modellen stellt sicher, dass vertrauliche Dokumente Ihren Rechner nie verlassen. So bleiben Vertraulichkeit und Datenschutzbestimmungen gewahrt.

Die Offline-Ausführung von Modellen eliminiert Netzwerklatenzen und liefert nahezu sofortige Ergebnisse für Aufgaben wie Zusammenfassung, Übersetzung und Inhaltserstellung.

Sie entscheiden, welche Modelle Sie ausführen möchten – Ollama bietet ein schlankes, erweiterbares Framework für verschiedene lokale LLMs, darunter die Ollama-Familie, DeepSeek, Mistral und mehr.

Schritt 1. Homebrew installieren (optional)

Wenn Sie Homebrew lieber zum Verwalten von Paketen unter macOS oder Linux verwenden möchten, installieren Sie es, indem Sie Folgendes ausführen:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

Wenn Sie Ollama mit einer anderen Methode installieren möchten, können Sie diesen Schritt überspringen.

Schritt 2. Ollama installieren

Um Ollama zu installieren, verwenden Sie das offizielle Installationsskript:

curl -fsSL https://ollama.com/install.sh | sh

Wenn Sie Homebrew verwenden, können Sie Ollama alternativ durch Ausführen von:

brew install ollama

Nach der Installation stellt Ollama Befehle zum Bereitstellen, Auflisten, Überprüfen und Ausführen von Modellen auf Ihrem Computer bereit.

Schritt 3. Lokalen KI-Server starten

Damit ONLYOFFICE mit Ihrem lokalen Ollama-Server kommunizieren kann, müssen Sie ihn so konfigurieren, dass er Anfragen von Webanwendungen akzeptiert.

Führen Sie im Terminal Folgendes aus:

export OLLAMA_ORIGINS=http://*,https://*,onlyoffice://*

So starten Sie Ollama jetzt und starten es beim Anmelden neu:

brew services start ollama

Oder, wenn Sie keinen Hintergrunddienst wollen/brauchen, können Sie einfach Folgendes ausführen:

ollama serve

Schritt 4. Herunterladen und Ausführen eines Modells

Öffnen Sie ein weiteres Terminalfenster und laden Sie das gewünschte Modell herunter. So installieren und starten Sie beispielsweise Llama 3.2:

ollama run llama3.2

Dadurch wird das Modell heruntergeladen und lokal gestartet. Sie können beliebig viele Modelle installieren. Jedes Modell wird in der ONLYOFFICE-Modellauswahlliste angezeigt. Weitere Modelle finden Sie in der offiziellen Ollama-Modellliste.

Hinweis: Stellen Sie vor der Installation sicher, dass Ihr Computer über ausreichend Arbeitsspeicher und Speicherplatz für Modelle verfügt.

Schritt 5. Das KI-Plugin in ONLYOFFICE einrichten

Installieren Sie zunächst das KI-Plugin für ONLYOFFICE-Editoren. Falls Sie das KI-Plugin bereits installiert haben, folgen Sie dem nächsten Schritt.

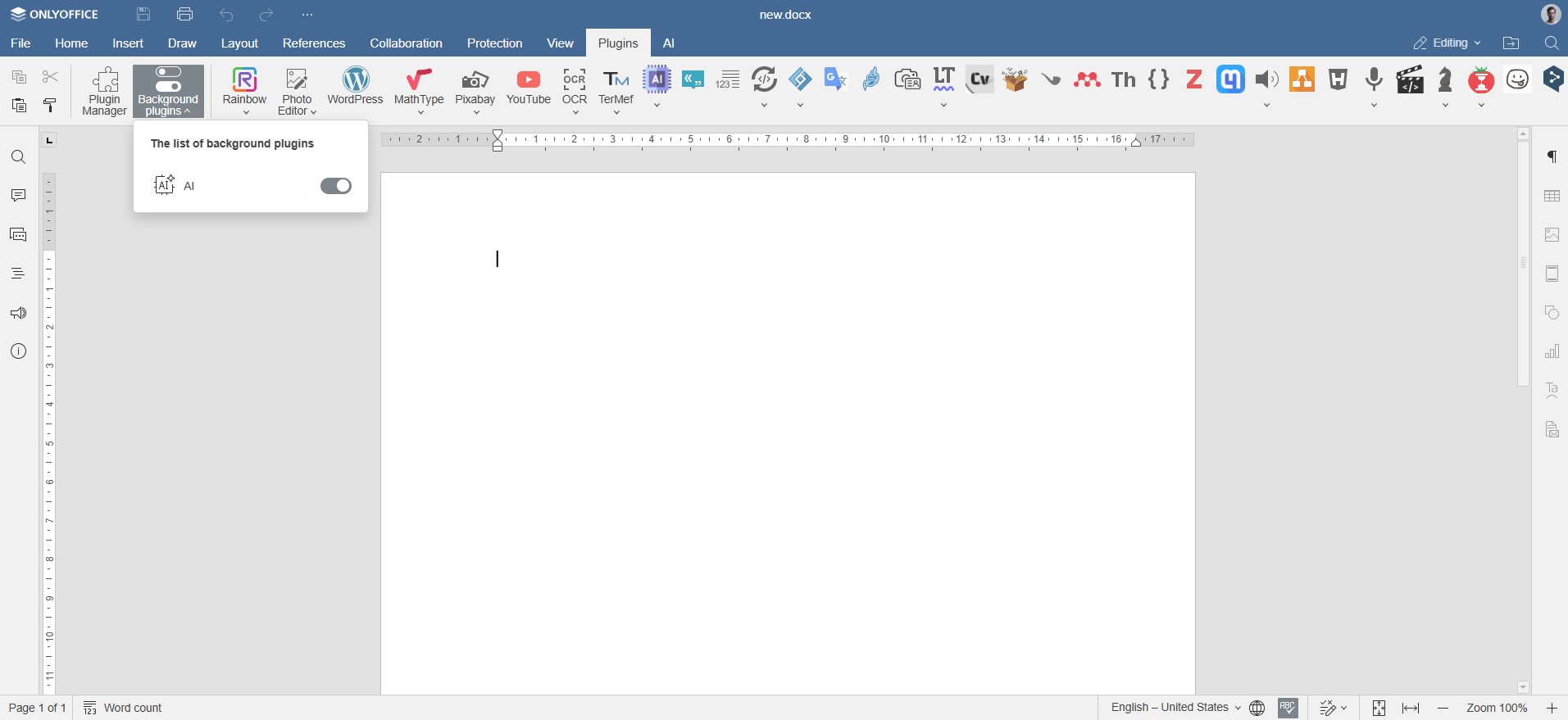

Öffnen Sie einen beliebigen ONLYOFFICE-Editor in einem Webbrowser. Gehen Sie zu Plugins -> Plugin-Manager, suchen Sie das KI-Plugin und klicken Sie auf Installieren.

Aktivieren Sie das Plugin über Plugins -> Plugins im Hintergrund.

Schritt 6. Ollama-Modelle hinzufügen

Navigieren Sie in ONLYOFFICE zur Registerkarte KI und klicken Sie auf Einstellungen. Klicken Sie unter KI-Modelle bearbeiten auf das Pluszeichen (+).

Wählen Sie Ollama als Anbieter und legen Sie die URL auf http://localhost:11434.

Wählen Sie Ihr installiertes Modell (z. B. llama3.2:latest) aus der Dropdown-Liste aus und bestätigen Sie.

Schritt 7. Aufgaben den Ollama-Modellen zuweisen

Kehren Sie zur KI-Konfiguration zurück. Wählen Sie aus der Dropdown-Liste die installierten KI-Modelle aus, die diese Aufgaben wie Textverarbeitung, Zusammenfassung oder Codegenerierung ausführen sollen, und speichern Sie die Einstellungen.

Das Modell ist nun verbunden und kann in den ONLYOFFICE-Editoren verwendet werden.

So verwenden Sie Ollama-KI-Modelle mit ONLYOFFICE-Editoren

Sobald Sie Ollama eingerichtet und Ihre bevorzugten Modelle verknüpft haben, können Sie direkt aus den ONLYOFFICE-Editoren heraus damit interagieren. Navigieren Sie zum Reiter KI oder klicken Sie einfach mit der rechten Maustaste auf einen ausgewählten Text, um auf KI-gesteuerte Funktionen zuzugreifen.

Öffnen Sie den Reiter KI oder klicken Sie mit der rechten Maustaste auf den ausgewählten Text, um Inhalte neu zu formulieren, zu erklären oder zusammenzufassen. Wählen Sie, wie Sie das Ergebnis einfügen möchten: Ersetzen Sie das Original, fügen Sie einen Kommentar hinzu oder platzieren Sie es unter dem Text.

Sie können KI-Modelle nutzen, um:

- Neue Inhalte oder Ideen für Ihre Berichte, Blogbeiträge oder E-Mails zu generieren

- Komplexe Dokumente oder Artikel sofort zusammenzufassen

- Texte zwischen Sprachen zu übersetzen

- Textklarheit und Grammatik zu verbessern

- Schnelle Programmierhilfe oder Beispiele zu erhalten (sofern das Modell dies unterstützt)

- Kontext und Verwendung von Begriffen in Ihren Texten zu untersuchen

Bitte beachten Sie: Die KI-Antworten werden von Drittanbietermodellen generiert. ONLYOFFICE übernimmt keine Verantwortung für die Richtigkeit der von diesen Tools erstellten Inhalte. Überprüfen Sie vertrauliche oder geschäftskritische Ergebnisse stets sorgfältig.

Erstellen Sie Ihr kostenloses ONLYOFFICE-Konto

Öffnen und bearbeiten Sie gemeinsam Dokumente, Tabellen, Folien, Formulare und PDF-Dateien online.